Dieses Projekt wurde durch Horizon Europe und das UTTER-Projekt gefördert.

Über UTTER

Stell dir vor, du besuchst ein Museum oder ein Geschäft und bekommst sofort eine Führung in deiner eigenen Sprache. Genau das verspricht UTTER, ein Forschungs- und Innovationsprojekt von Horizon Europe, koordiniert von der Universität Amsterdam. UTTER steht für Unified Transcription and Translation for Extended Reality und entwickelt die nächste Generation von Sprachtechnologie für XR – darunter schnelle Transkription, Echtzeit-Übersetzung und klare Zusammenfassungen von Gesprächen. Das Ziel ist einfach und wirkungsvoll: mehrsprachige Unterstützung in realen Situationen, mit KI, die Kontext, Tonfall und tatsächliche Bedürfnisse im Moment versteht.

ZAUBARs Rolle

ZAUBAR ist dem UTTER-Projekt beigetreten, um diese Sprachfähigkeiten aus dem Meetingraum in reale Umgebungen zu bringen. Unser Pilot VISIXR (Vision AI for XR) macht die UTTER-Technologie zu einem interaktiven Erlebnis ohne App-Installation. Unser Agent reagiert auf Inhalte, die du siehst – ob Bild, Szene, Produktseite oder eine beliebige Website – sodass du in deiner Sprache fragen kannst und Antworten im jeweiligen Kontext erhältst. Der Agent kann den relevanten Bereich hervorheben, per Sprache antworten oder Text anzeigen und mit einer kurzen Zusammenfassung nachfassen, damit das Wichtigste hängen bleibt.

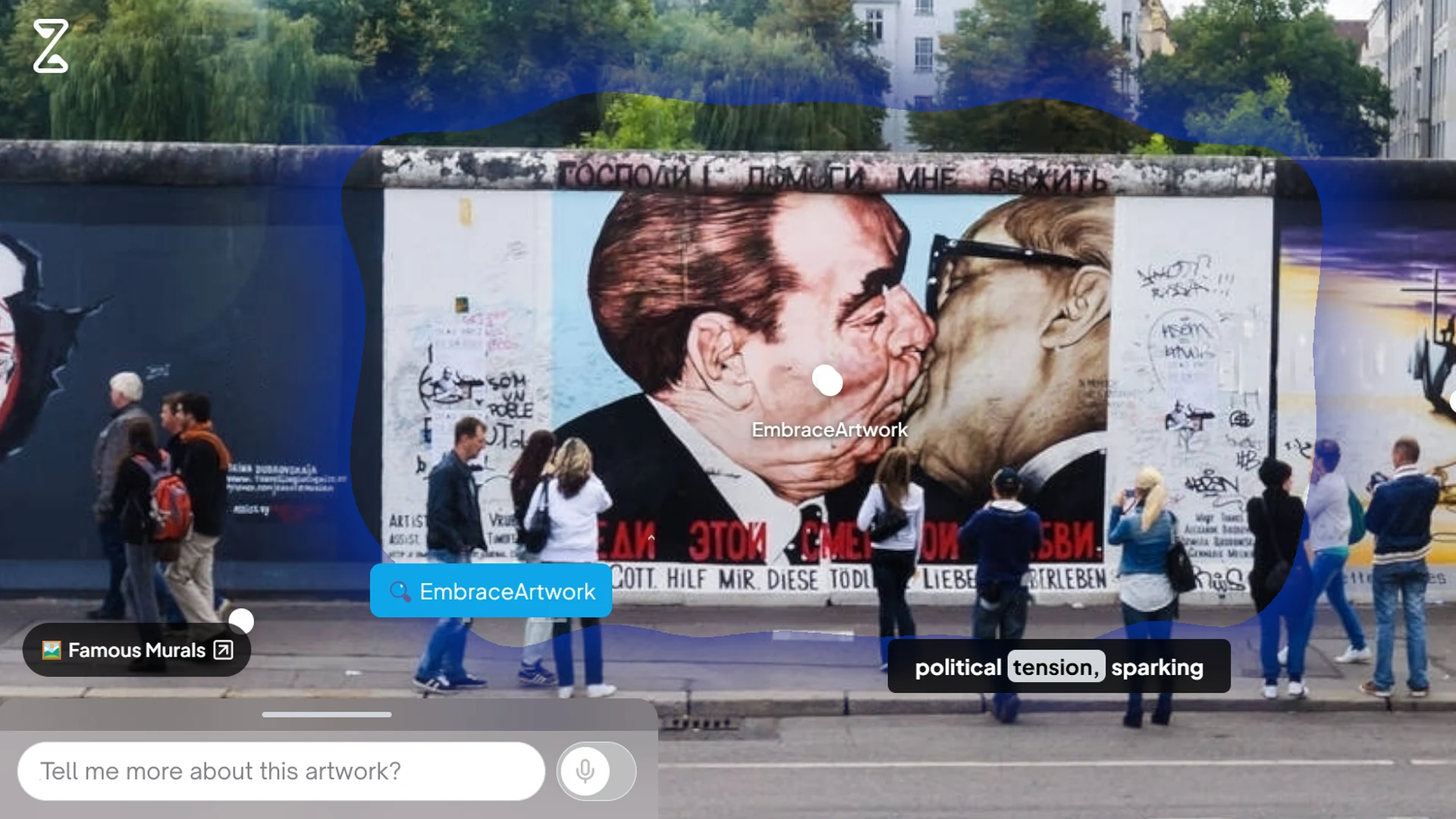

Was dieses System von einem gewöhnlichen Chatbot unterscheidet, ist die Verbindung aus Sprache und Bild. Der Agent erkennt, was auf dem Bildschirm ist, und reagiert passend zur Situation. Denk an ein Foto eines Berliner-Mauer-Wandgemäldes: Du kannst die Sprache wechseln, einen Sprechstil wählen, eine kurze Übersicht oder eine ausführlichere Erklärung anfordern und Hotspots antippen, um mehr über einzelne Details zu erfahren. Du wechselst mühelos von „Erzähl mir mehr über dieses Kunstwerk“ zu „Wer hat es gemalt, wann, und warum ist es wichtig?“, ohne den Faden zu verlieren. All das wird durch eine Echtzeit-Pipeline für Speech-to-Text, Intent-Erkennung und Text-to-Speech ermöglicht, kombiniert mit Bildanalyse, die das Sichtbare segmentiert, damit der Agent präzise darauf Bezug nehmen kann – ausgeliefert über ein Unity/WebGL-Frontend für den einfachen Zugriff im Browser.

Für Unternehmen und Institutionen eröffnet das praktische Möglichkeiten. Marken und Händler können Bilder und Displays in interaktive Assistenten verwandeln, die Fragen beantworten und Merkmale vergleichen. Der Agent kann auf einen verifizierten Wissensbestand eines Unternehmens zugreifen – so behältst du die Kontrolle über Bilder, Produktdaten und FAQs und stellst sicher, dass Antworten korrekt und markenkonform sind. Museen und Kulturorte können internationale Besucherinnen und Besucher mit Erklärungen in deren Sprache willkommen heißen. Trainerinnen, Trainer und Lehrkräfte können Lernende durch komplexe Visualisierungen führen, wobei einfache Fragen zur passenden Detailtiefe führen. Wir verfeinern das Erlebnis weiter und bringen es in laufende ZAUBAR-Projekte ein – mit dem Ziel einer verlässlichen Plug-and-Play-Komponente, die mehrsprachige Unterstützung, kurze Zusammenfassungen und szenenbezogene Antworten für Touren, Ausstellungen, Events und Lernumgebungen liefert.

.webp)

.svg)

.svg)

.svg)

.svg)

.svg)

%201.svg)

.webp)